交流群的风格突然骤变,没有了往日的灌水扯淡,居然聊起了技术。

看了大家的全部的聊天记录,发现问题并没解决。群里难得这么多人聊技术,主动勾搭一起看看是什么问题。

现场复现

了解到其架构是 apache + php ,群友也是临时接受的祖传代码,项目也不是很清楚。

大概了解其问题是这样,apache 子进程一直异常退出,导致前台访问大概有 1/10 的概率网页直接打不开,问题还是很严重的,查看 apache 错误日志如下

$ sudo tail -f /var/log/httpd/error_log

[Sun Jun 13 19:32:25.660349 2021] [core:notice] [pid 23340] AH00052: child pid 20605 exit signal Bus error (7)

[Sun Jun 13 19:32:25.660413 2021] [core:notice] [pid 23340] AH00052: child pid 20606 exit signal Bus error (7)

[Sun Jun 13 19:35:39.862368 2021] [core:notice] [pid 23340] AH00052: child pid 21332 exit signal Bus error (7)

[Sun Jun 13 19:35:50.872363 2021] [core:notice] [pid 23340] AH00052: child pid 21369 exit signal Bus error (7)

[Sun Jun 13 19:39:43.079650 2021] [core:notice] [pid 23340] AH00052: child pid 18595 exit signal Bus error (7)

[Sun Jun 13 19:42:08.210353 2021] [core:notice] [pid 23340] AH00052: child pid 21348 exit signal Bus error (7)

[Sun Jun 13 19:42:16.221076 2021] [core:notice] [pid 23340] AH00052: child pid 21331 exit signal Bus error (7)

[Sun Jun 13 19:42:16.221177 2021] [core:notice] [pid 23340] AH00052: child pid 23156 exit signal Bus error (7)

[Sun Jun 13 19:44:11.329344 2021] [core:notice] [pid 23340] AH00052: child pid 27824 exit signal Bus error (7)可以使用strace来看看,背后到底是什么问题

$ ps -ef|grep apache首先看到主进程 id 是 23340,这里需要跟着其子进程,所以我执行了如下命令

$ sudo strace -o strace.log -s 1024 $(pidof "/usr/sbin/httpd" -o 23340|sed 's/\([0-9]*\)/-p \1/g')

strace: Process 26212 attached

strace: Process 26211 attached

strace: Process 26191 attached

strace: Process 25940 attached

...参数大概解释下

| code | 释义 |

|---|---|

| -o strace.log | 输出 strace 日志到 strace.log |

| -s 1024 | 当系统调用的某个参数是字符串时,最多输出指定长度的内容,默认是32个字节 |

| pidof "/usr/sbin/httpd" -o 23340 | 排除主进程 23340 之外的 httpd 子进程 |

然后新开一个窗口监控日志

$ sudo tail -f strace.log |grep SIGBUS -B 500

28741 open("/xxxx/www/data/cache/xxx.php", O_WRONLY|O_CREAT|O_TRUNC, 0666) = 15

28741 write(15, "<?php defined('DYMall') or exit('Access Invalid!'); return array ( ) ?>", 71) = 71

28741 close(15)

...

28741 open("/xxxx/www/data/cache/xxx.php", O_RDONLY) = 15

28741 fstat(15, {st_mode=S_IFREG|0644, st_size=71, ...}) = 0

28741 fstat(15, {st_mode=S_IFREG|0644, st_size=71, ...}) = 0

28741 fstat(15, {st_mode=S_IFREG|0644, st_size=71, ...}) = 0

28741 mmap(NULL, 71, PROT_READ, MAP_SHARED, 15, 0) = 0x7f584aee8000

28741 --- SIGBUS {si_signo=SIGBUS, si_code=BUS_ADRERR, si_addr=0x7f584aee8000} ---

28741 chdir("/etc/httpd") = 0

28741 rt_sigaction(SIGBUS, {SIG_DFL, [], SA_RESTORER|SA_INTERRUPT, 0x7f58499bc5e0}, {SIG_DFL, [], SA_RESTORER|SA_RESETHAND, 0x7f58499bc5e0}, 8) = 0

28741 kill(28741, SIGBUS) = 0

28741 rt_sigreturn({mask=[]}) = 140017190993928

28741 --- SIGBUS {si_signo=SIGBUS, si_code=SI_USER, si_pid=28741, si_uid=48} ---

28741 +++ killed by SIGBUS +++SIGBUS 在用户态最为常见的场景,也最容易触发,通常来说根本原因都是进程 mmap 了一个文件后,另外的进程把这个文件截断了,导致 mmap 出来的某些内存页超出文件的实际大小,访问那些超出的内存页就会触发 SIGBUS

根据上面打开的文件名是xxx.php,从业务属性上分析,既然是缓存文件,就存在过期了被重写的情况。沿着这个思路,继续分析。

验证文件大小变化

可以看到上面打开文件的时候大小是71,所以我通过监控文件的大小变化来验证文件是否被重写。

$ while :; do cat /xxxx/www/data/cache/xxx.php|wc -L ;done屏幕滚动太快几乎一直都是 71 ,那么我们过滤下 71

$ while :; do cat /xxxx/www/data/cache/xxx.php|wc -L ;done|grep -v 71发现文件确实在少数情况下会变为 0 个字节,初步定位是缓存文件被重写了,那么是谁动了这个缓存呢?

确认文件写操作来源

首先想到的是,是不是有什么计划任务在定期清理这个缓存呢?或者说这个服务器上的其他非 web 项目里面的脚本在处理。为了确认这一点,所以我安装文件审计工具,来监控文件的操作记录。

$ sudo yum -y install audit auditd-libs监控xxx.php文件的写入操作

$ sudo auditctl -w /xxxx/www/data/cache/xxx.php -p w结果类似于

time->Mon Jun 14 21:21:39 2021

type=PROCTITLE msg=audit(1623676899.778:1883303): proctitle=2F7573722F7362696E2F6874747064002D44464F524547524F554E44

type=PATH msg=audit(1623676899.778:1883303): item=1 name="/xxxx/www/data/cache/xxx.php" inode=30151674 dev=fd:11 mode=0100644 ouid=48 ogid=48 rdev=00:00 objtype=NORMAL

type=PATH msg=audit(1623676899.778:1883303): item=0 name="/xxxx/www/data/cache/" inode=30151667 dev=fd:11 mode=040755 ouid=48 ogid=48 rdev=00:00 objtype=PARENT

type=CWD msg=audit(1623676899.778:1883303): cwd="/xxxx/www"

type=SYSCALL msg=audit(1623676899.778:1883303): arch=c000003e syscall=2 success=yes exit=16 a0=55b452b93078 a1=241 a2=1b6 a3=2a items=2 ppid=31318 pid=18269 auid=4294967295 uid=48 gid=48 euid=48 suid=48 fsuid=48 egid=48 sgid=48 fsgid=48 tty=(none) ses=4294967295 comm="httpd" exe="/usr/sbin/httpd" key=(null)收集一段时间的日志,用 shell 做下统计

$ sudo ausearch -f /xxxx/www/data/cache/xxx.php |grep "exe="|awk '{print $12,$26}'|sort|uniq -c

44200 ppid=31318 exe="/usr/sbin/httpd"发现都是来自于/usr/sbin/httpd,并没有CLI模式的其他脚本在处理这个文件。

sudo auditctl -D清理掉监控,还有一个可能就是 web 多进程之间读写冲突了

多进程文件读写冲突的解决方案

首先写了两个简单的 demo 代码

aa.php

function setFileLock($filename, $lock)

{

$fp = fopen($filename . ".lock", "w+");

flock($fp, $lock);

return $fp;

}

function releaseLock($fp)

{

flock($fp, LOCK_UN);

}

$filename = "cc.log";

// mock 数据

file_put_contents($filename, "100");

$fp = fopen($filename, "r");

if ($lockfp = setFileLock($filename, LOCK_SH)) {

$n = 10;

while ($n > 0) {

sleep(1);

printf("%d %d\n", time(), --$n);

}

echo fgets($fp);

releaseLock($lockfp);

}

fclose($fp);bb.php

function setFileLock($filename, $lock)

{

$fp = fopen($filename . ".lock", "w+");

flock($fp, $lock);

return $fp;

}

function releaseFileLock($fp)

{

flock($fp, LOCK_UN);

fclose($fp);

}

$filename = "cc.log";

if ($lockfp = setFileLock($filename, LOCK_EX)) {

$fp = fopen($filename, "w+");

echo time();

fwrite($fp, 200);

releaseFileLock($lockfp);

}

fclose($fp);aa.php往cc.log写入 100,然后增加共享锁,睡眠 10s 之后,输出读取cc.log的内容bb.php先获取排它锁 往cc.log写入 200

demo 执行逻辑:

- 窗口 A 执行

php aa.php - 窗口 B 执行

php bb.php - 窗口 C 执行

tail -f cc.log

就能看到效果:在 aa.php 执行完之前,cc.log的内容不变,在aa.php执行完之后,才会变。

需要注意,在对文件进行

fopen($filename, "w+")的时候,就已经将文件清空了,所以加锁需要在fopen目标文件之前,我的方式是增加一个文件一一对应的锁文件。

实际代码定位

然后根据系统调用里面的字符串关键字,搜到了相关的缓存操作代码

28741 write(15, "<?php defined('DYMall') or exit('Access Invalid!'); return array ( ) ?>", 71) = 71改完之后发现线上还是有问题,本来我已经怀疑人生了,难道我的思路是错的???

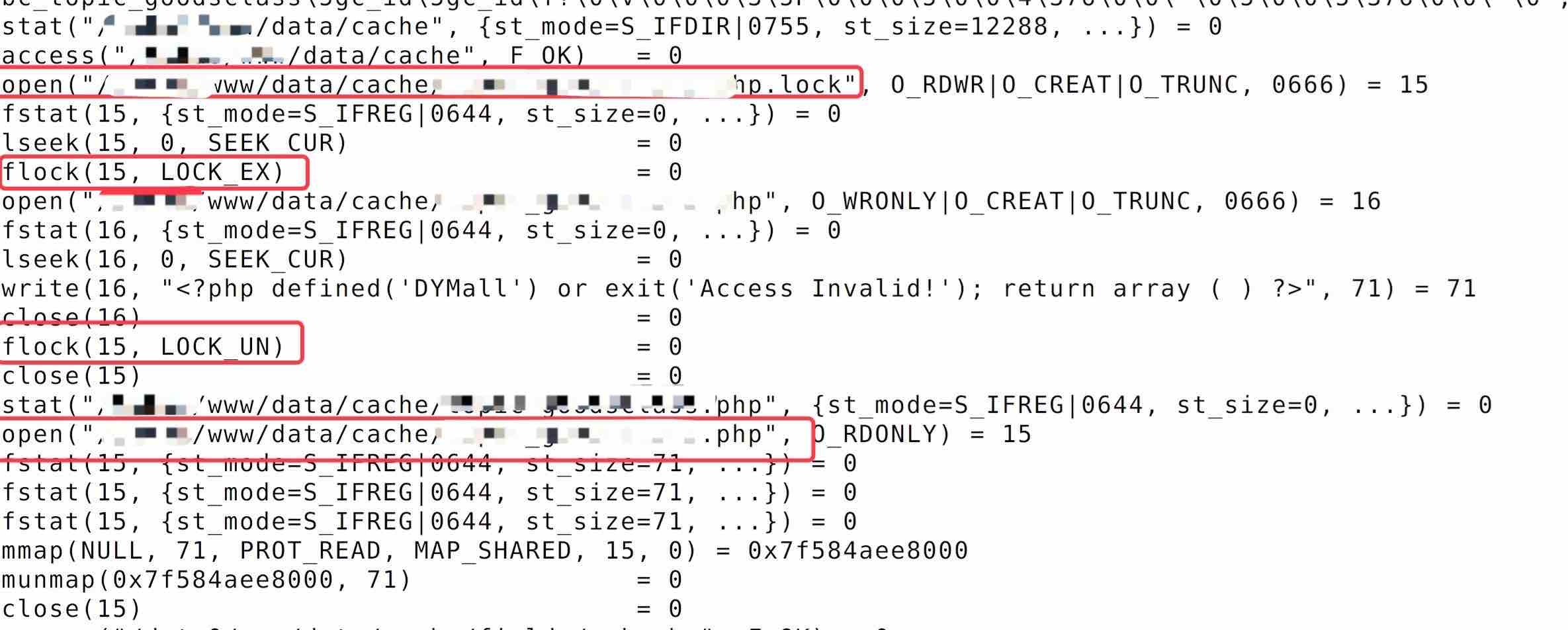

休息了一会,还是通过系统调用发现写的时候有设置LOCK_EX和释放LOCK_UN,但是读取的时候并没有走我增加的共享锁的逻辑

前三个红框为写逻辑,最后一个红框为读逻辑,所以我恍然大悟,肯定是有别的地方在读,只能说祖传代码太乱。

然后根据个人经验,按图索骥找到了另外一个缓存文件的读取逻辑,然后再次修改发布,线上问题没有再复现。

问题解决,跑路哥给我发来红包,我心满意足的接受了。

总结

- 首先通过

strace复现SIGBUS的场景 - 预计是文件在多进程模型下,并发读写导致的问题

- 通过

auditctl监控统计文件的写操作来源均为httpd没有其他进程来修改 - 通过读加共享锁、写加排它锁,线上还是有问题

- 再次根据

strace发现读的地方另有他处,根据经验,补上,问题修复

不足的地方:最后定位过于依靠个人经验,不够系统化。

小想法:可以弄一个扩展使用 zend_set_user_opcode_handler 来监控自定义函数和方法和系统方法和函数调用链,然后的方法调用在 zend_set_user_opcode_handler里面打印,这样就能方便排查祖传代码的一些业务逻辑问题了。

隔了几天真的就写了一个这样的工具 https://mengkang.net/1473.html

如果有其他更快更简单的方案,大家留言告诉我。我的公众号:程序员跑路笔记,期待大家的关注。